腾讯科技讯 3月19日消息,据国外媒体报道,英伟达备受期待的GTC大会周一在美国圣何塞会议中心正式开幕。为巩固其作为人工智能公司首选供应商的市场地位,英伟达在GTC大会上发布了运行人工智能模型的新一代Blackwell GPU架构及B100 GPU。

自OpenAI的ChatGPT在2022年底开启人工智能热潮以来,英伟达的营收已上涨了两倍以上,股价更是上涨了四倍多。英伟达的高端服务器GPU对于训练和部署大型人工智能模型至关重要。像微软和Meta这样的公司已投入数十亿美元购买此类芯片。

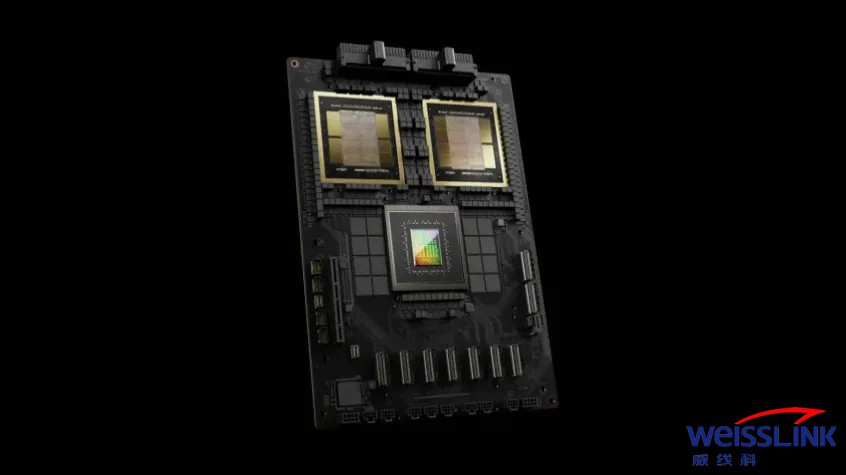

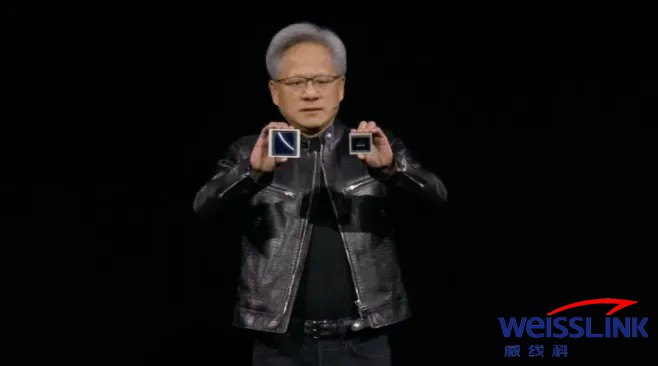

英伟达周一推出的新一代AI图形处理器被命名为Blackwell,首款基于Blackwell的AI加速卡名为GB200,将于今年晚些时候上市。英伟达正在用更强大的芯片吸引客户,以刺激新订单。目前,企业和软件开发商仍在争相获得当前一代的“Hopper”H100s芯片。英伟达首席执行官黄仁勋周一在GTC大会上表示:“Hopper很棒,但我们需要更强大的GPU。”

英伟达周一还推出名为NIM的创新软件,使部署人工智能变得更容易,为客户在竞争日益激烈的领域中坚持使用英伟达芯片提供了又一个理由。

英伟达高管表示,该公司越来越不像是一家以盈利为目的的芯片提供商,而是像微软或苹果一样的平台提供商,让其他公司可以在英伟达的平台上开发软件。黄仁勋对此表示:“Blackwell不是一款芯片,它是平台的名称。”

英伟达企业副总裁马努维尔·达斯(Manuvir Das)在接受采访时表示:“可销售的商业产品是GPU,而软件旨在帮助人们以不同方式使用GPU。当然,我们还是那样做了。但真正改变的是,我们现在真的有了商业软件业务。”达斯表示,英伟达的新软件将使在英伟达的任何GPU上运行程序变得更容易,甚至是那些可能更适合部署但不适合构建人工智能的旧GPU。“如果你是一名开发人员,你有一个有趣的模型,你希望人们采用它,如果你把它放在NIM中,我们将确保它在我们所有的GPU上都是可运行的,”达斯说。

英伟达每隔一年都会更新其GPU架构,从而实现GPU性能的大幅提升。过去一年发布的许多人工智能模型都是在该公司于2022年宣布的Hopper架构上训练的,被用于H100等芯片。英伟达表示,基于Blackwell架构的处理器,如GB200,为人工智能公司提供了巨大的性能升级,可达到20 petaflops或每秒2万亿次计算的AI性能,是H100的五倍。英伟达表示,额外的计算能力将使人工智能公司训练更大、更复杂的模型,推理大语言模型性能比H100提升30倍。

Blackwell GPU把两个独立制造的芯片集成到一个由台积电制造的芯片中。英伟达还推出名为GB200 NVLink 2的服务器,结合了72颗Blackwell GPU和其他旨在训练人工智能模型的英伟达配件。

亚马逊、谷歌、微软和甲骨文将通过云服务出售对GB200的访问权限。GB200将两颗B200 Blackwell GPU与一个基于Arm的Grace CPU配对。英伟达表示,亚马逊云服务AWS将建立一个拥有2万颗GB200芯片的服务器集群。

英伟达还表示,该系统可以部署27万亿个参数的模型,比目前最大的模型,如拥有1.7万亿个参数GPT-4都大得多。许多人工智能研究人员认为,拥有更多参数和数据的更大模型可能会释放新的能力。英伟达没有提供新GB200或其所用系统的成本。据分析师估计,英伟达基于Hopper的H100每颗芯片的成本在2.5万美元至4万美元之间,整个系统的成本高达20万美元。

NIM软件

英伟达还宣布将在其英伟达企业软件订阅中添加一款名为NIM的新产品。NIM让使用旧款英伟达GPU进行推算或运行AI软件的过程变得更容易,并允许企业继续使用它们已有的数亿颗英伟达GPU。与新人工智能模型的初始训练相比,使用NIM推算需要更少的算力。NIM使那些希望运行自有人工智能模型的公司能够实现这一目标,不再从OpenAI等公司购买访问人工智能结果的服务。

英伟达的这一策略是让购买基于英伟达服务器的客户注册Nvidia AI Enterprise服务,每颗GPU每年的许可费用为4500美元。英伟达将与微软或Hugging Face等人工智能公司合作,确保它们的人工智能模型经过调整,可以在所有兼容的英伟达芯片上运行。使用NIM,开发人员可以在自己的服务器或基于云端的英伟达服务器上高效运行模型,无需漫长的配置过程。英伟达还表示,该软件还将帮助人工智能在配备GPU的笔记本电脑上运行,而不是在云端服务器上运行。